Wie KI den Arbeitsmarkt verändern wird, ist noch immer eher spekulativ abzuschätzen.

Der Beitrag Entwertet KI Universitäten und akademische Abschlüsse? erschien zuerst auf .

Wieder ein brutaler Gewaltakt, wieder dieselbe Leerstelle: Nach dem lebensgefährlichen Angriff auf einen Zugbegleiter in einem Regionalexpress bei Landstuhl bleibt die entscheidende Frage unbeantwortet – wer ist der Täter wirklich? In der offiziellen Mitteilung des Polizeipräsidium Westpfalz wird lediglich ein „26-jähriger Angreifer“ erwähnt, weitergehende Angaben zur Identität fehlen vollständig, wie das Polizeipräsidium Westpfalz berichtet.

Der Ablauf ist schnell erzählt: Fahrscheinkontrolle, kein Ticket, Verweis aus dem Zug – dann eskaliert die Situation. Der Zugbegleiter wird unvermittelt angegriffen, erleidet lebensbedrohliche Verletzungen und muss vor Ort reanimiert werden. Fahrgäste greifen ein, Polizei und Rettungskräfte übernehmen. Der Tatverdächtige wird festgenommen, Ermittlungen wegen versuchten Totschlags laufen. Doch während der Zustand des Opfers offen benannt wird, bleibt der Täter anonymisiert.

Dieses Weglassen ist kein Zufall, sondern Routine. Alter und Geschlecht gelten plötzlich als ausreichend, alles Weitere wird unter Verschluss gehalten. Dabei ist es genau diese Informationslücke, die Misstrauen schürt. Wer Gewalt erklären will, muss sie auch vollständig benennen. Stattdessen entsteht der Eindruck, dass relevante Details bewusst ausgespart werden – nicht aus ermittlungstaktischen Gründen, sondern aus politischer Bequemlichkeit.

Die Polizei hätte die Möglichkeit, transparent zu informieren, entscheidet sich aber erneut für das kontrollierte Schweigen. Das Ergebnis: Öffentlichkeit und Fahrgäste bleiben mit einem diffusen Sicherheitsgefühl zurück, während sich die Serie schwerer Gewalttaten im öffentlichen Raum fortsetzt – stets begleitet von derselben sprachlichen Schonung des Täters.

Authorities overseeing some of Britain’s most famous countryside landscapes are launching targeted outreach programs aimed at ethnic minority communities, after a government-commissioned review warned rural areas are widely perceived as a "white" and unwelcoming space.

"The countryside is seen by both black, Asian and minority ethnic groups and white people as very much a ‘white’ environment," the report stated, "We are all paying for national landscapes through our taxes, and yet sometimes on our visits it has felt as if National Parks are an exclusive, mainly white, mainly middle‑class club, with rules only members understand and much too little done to encourage first time visitors."

Critics say the initiative reflects misplaced government priorities. Michael McManus, director of research at the Henry Jackson Society, told Fox News Digital: "At a time of low growth, high taxes and stretched public services, it’s astonishing that ministers are spending time and money worrying about the ‘whiteness’ of the countryside. Government exists to grow the economy and fix real problems, not to indulge in culture war distractions that deliver nothing for working people."

The initiatives stem from the 2019 Landscapes Review, commissioned by the Department for Environment, Food & Rural Affairs (DEFRA) and led by author Julian Glover. The review concluded that England’s protected landscapes often feel disconnected from large parts of the population.

LIZ PEEK: TRUMP DECLARES WAR ON WOKE—AND THIS BELOVED MUSEUM IS IN HIS CROSSHAIRS

The review also criticized the leadership of protected landscapes, arguing that governance bodies do not reflect the country they serve. "Of the almost 1,000 people on National Park and AONB boards today, the great majority are male… and a tiny fraction are of black, Asian or minority ethnicities," the report said, calling that imbalance "wrong for organizations which are funded by the nation to serve everyone."

Following the review, organizations representing National Landscapes, formerly known as Areas of Outstanding Natural Beauty, have published updated management plans outlining steps to attract more diverse visitors. According to individual plans published between 2024 and 2025, and as reported by U.K. outlets including LBC and GB News, the measures apply to landscapes including the Cotswolds, the Chilterns, the Malvern Hills and others.

AMERICAN HISTORY WON'T BE DISPLAYED 'IN A WOKE MANNER' AT SMITHSONIAN, TRUMP SAYS

Under those plans, the Chilterns National Landscape will launch targeted outreach programs in Luton and High Wycombe, areas with large Muslim populations. One barrier cited in follow-up research was concern among some visitors about unleashed dogs in rural areas.

The Cotswolds National Landscape referenced the DEFRA findings directly, saying it is seeking to broaden its appeal to reach "the widest demographic."

In its own management strategy, the Malvern Hills National Landscape said many minority communities lack a generational connection to the countryside because parents and grandparents "did not always feel welcome in it." The plan added that while many white English visitors value solitude, ethnic minority visitors may be more inclined toward group or family-based activities.

Other landscapes raised similar concerns. Nidderdale National Landscape in North Yorkshire warned that ethnic minority visitors may worry about how they will be received in unfamiliar rural settings. Dedham Vale, Surrey Hills, and Suffolk and Essex Coast Heaths said they aim to identify and address barriers limiting access for under-represented groups, including people without English as a first language.

Together, the plans signal a broader shift in how Britain’s publicly funded countryside is managed, as landscape authorities face growing pressure to demonstrate cultural relevance to a changing society, even as critics warn the focus risks sidelining economic priorities and traditional conservation goals.

Fox News Digital reached out to the Department for Environment, Food & Rural Affairs in England for comment but did not receive a response before publication.

Unbekannte übermalen in Arnsberg eine Regenbogentreppe mit den Nationalfarben. Die örtlichen Grünen reagieren empört. Jeder könne sich die Deutschlandfarben in den Garten hängen – aber nicht in den öffentlichen Raum. Dazu nehmen sie extra ein bizarres Video auf.

Dieser Beitrag Regenbogentreppe übermalt Deutschlandfarben sorgen bei Arnsberger Grünen für Schnappatmung wurde veröffentlich auf JUNGE FREIHEIT.

Seit 2024 setzt sich die Partei dafür ein, nun werden bald die Namensschilder ausgetauscht. Der queerpolitische Sprecher freut sich über ein „großes und vor allem sichtbares Signal“. Dann redet er von einem weiteren Regenbogen-Projekt der CDU.

Dieser Beitrag Kulturkampf Dank CDU heißt eine Berliner U-Bahnstation jetzt „Regenbogenkiez“ wurde veröffentlich auf JUNGE FREIHEIT.

Der frühere Wall-Street-Vermögensverwalter und Finanzanalyst Ed Dowd von PhinanceTechnologies.com warnte bereits im Dezember, wir befänden uns „am Beginn eines Kreditzerstörungszyklus“.

Der renommierte Hedgefonds BlackRock war nun das jüngste Opfer dieser Kreditzerstörung, mit der Schlagzeile dieser Woche:

„BlackRock senkt den Wert seines Private-Debt-Fonds um 19 Prozent und verzichtet auf Gebühren.“

Dowd hatte recht – schon wieder.

Laut Dowds jüngstem Bericht mit dem Titel „US Economy Outlook 2026“ wird es noch deutlich schlimmer. Dowd sagt:

„Das ist eine große Prognose, und das, was passieren wird, passiert nicht sehr oft …

Wir werden in Zukunft versuchen, den Tiefpunkt zu bestimmen, aber im Moment habe ich in meiner gesamten Karriere noch nie ein Risiko in diesem Ausmaß gesehen.

Das hat sich über längere Zeit aufgebaut. … Mit meiner Prognose für 2025 lag ich nicht falsch. Der Aktienmarkt ist zwar um 17 Prozent gestiegen, aber der Rest der Wirtschaft ist implodiert. Der Immobilienmarkt begann zu kippen …

Leider ist dies eine derart große Blase, weil man die Probleme immer weiter aufgeschoben hat … die Wahrscheinlichkeit, dass dies sehr schnell passiert, ist seit Anfang 2025 exponentiell gestiegen.“

Dowd erklärt weiter:

„Die drei grundlegenden Risiken, die wir für die US-Wirtschaft im Jahr 2026 sehen …

Es gibt zwei interne Risiken und ein externes Risiko.

Das erste Risiko ist eine US-Immobilienkrise / ein ‚White-Swan‘-Ereignis. Einwanderer sind gekommen und haben die Lücke gefüllt.

Das ist nun vorbei. … Abschiebungen werden sich über die nächsten ein bis zwei Jahre fortsetzen, und das wird weiterhin Druck auf den Immobilienmarkt ausüben.

Die Erschwinglichkeit ist eine Katastrophe. Die Einkommen erlauben es den Menschen nicht, Häuser zu diesen Preisen zu kaufen.

Der einzige Weg, dies zu korrigieren, ist ein Rückgang der Immobilienpreise um 25 bis 30 Prozent in den nächsten zwei Jahren. Das würde den Weg für eine Erholung ebnen.“

Dowd fährt fort:

„Das zweite Risiko für die US-Wirtschaft ist eine Aktienmarktblase …

Die Bewertungen sind so schlecht wie zur Zeit der Dotcom-Blase.

Das wird durch die KI-Blase angetrieben, und wir sehen dort bereits erste Risse.

Wir erwarten, dass diese Blase noch in diesem Jahr platzt.

Das dritte Risiko ist China.

China tritt in die akute Phase seiner Wirtschaftskrise ein.

Das wird zu einer globalen Ansteckung führen. Es wird Japan und Südkorea treffen und auf die USA übergreifen. … Es wird eine Liquiditätskrise sein, und genau deshalb sind wir beim US-Dollar optimistisch.“

(Dowd verfügt über neue, hochmoderne Analysen zu China für institutionelle Investoren. Sie enthalten schockierende neue und bislang unveröffentlichte Details darüber, wie ernst die Lage in China tatsächlich ist.)

Dowd weist außerdem darauf hin:

„Wir haben im Jahr 2026 mit starkem Gegenwind zu rechnen …

Wir glauben, dass die ersten Probleme im Schattenbankensystem beginnen werden – also bei Private Equity, Private-Credit-Fonds und all den Krediten von Nicht-Einlagen-Finanzinstituten, die Geschäftsbanken in den letzten zwei Jahren vergeben haben. (Siehe BlackRock-Geschichte oben.)

Das gesamte Kreditwachstum kam aus dieser Quelle.

Im klassischen Industrie- und Unternehmenskreditbereich gab es kein Wachstum. Alles spielte sich im Schattenbankensystem ab.“

Worüber macht sich Dowd keine Sorgen? Trotz des heftigen Einbruchs bei Gold und Silber am Freitag sagt Dowd:

„Ich bin weiterhin optimistisch für Gold und Silber, und mein Kursziel für Gold bis 2030 liegt bei 10.000 US-Dollar pro Unze.

Es wird jetzt konsolidieren. Ist es das Ende? Das glaube ich nicht.

Es gibt eine enorme Nachfrage großer Banken nach Gold und – im Fall von Silber – von industriellen Abnehmern nach dem Metall.“

Es gibt noch deutlich mehr in dem 44-minütigen Interview.

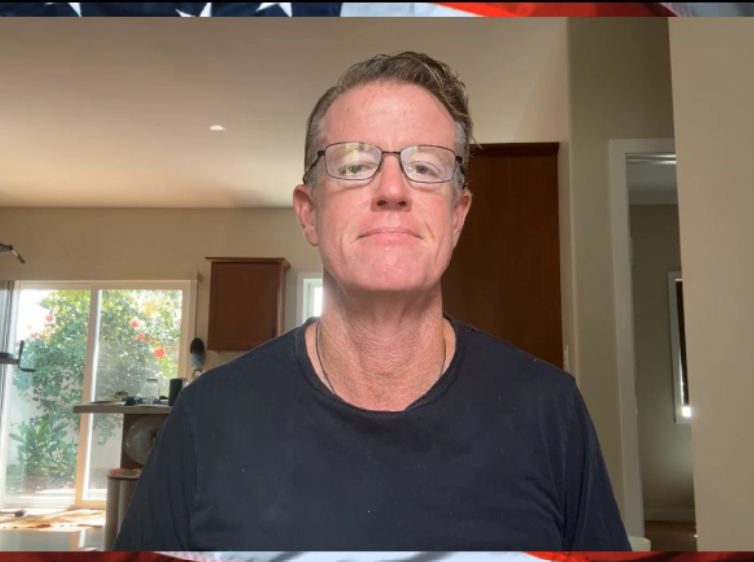

Begleiten Sie Greg Hunter von USAWatchdog in einem One-on-One-Gespräch mit Vermögensverwalter und Investmentexperte Ed Dowd, in dem dieser seinen neuesten Bericht „US Economy Outlook 2026“ vorstellt (Interview vom 31.01.2026).

In Paris sammeln Ermittler Beweise in den Räumlichkeiten von X. Sie machen der Plattform eine Reihe von Vorwürfen, darunter Beihilfe zum Besitz kinderpornographischen Materials. Sagt Elon Musk dazu demnächst aus?

Dieser Beitrag Paris Französische Staatsanwaltschaft durchsucht Büros von X wurde veröffentlich auf JUNGE FREIHEIT.

Abschiebung angekündigt, Abschiebung geplatzt: In einigen Bundesländern finden sechs von zehn Rückführungen nicht statt. Asylbewerber tauchen unter, legen Atteste vor oder werden kurz vor dem Abflug gewalttätig.

Dieser Beitrag Erschreckende Zahlen In diesen Bundesländern scheitert die Mehrheit der Abschiebungen wurde veröffentlich auf JUNGE FREIHEIT.

Es ist eine auffällige Verschiebung, die sich in den vergangenen Jahren vollzogen hat: Künstliche Intelligenz ist nicht mehr primär ein Forschungsfeld, nicht mehr nur ein industrielles Innovationsversprechen, sondern ein politisches Pflichtprojekt. Kaum ein Regierungspapier, kaum eine wirtschaftspolitische Rede kommt ohne den Verweis auf KI aus. Sie gilt als Schlüsseltechnologie, als Wachstumsmotor, als Sicherheitsfaktor und zunehmend als Maßstab geopolitischer Relevanz. Diese Erzählung ist bemerkenswert, weil sie weniger aus einer klar formulierten gesellschaftlichen Zielsetzung gespeist wird als aus einem Gefühl: der Angst, zurückzufallen. Von Günther Burbach.

Dieser Beitrag ist auch als Audio-Podcast verfügbar.

Wer heute nicht massiv in KI investiert, so lautet das implizite Narrativ, riskiert morgen den Verlust von Wohlstand, Sicherheit und Einfluss.

Der weltweite KI-Schub begann nicht mit einer breiten öffentlichen Debatte über Sinn, Nutzen oder Risiken. Er begann mit Vergleichen, Ranglisten und Warnungen. Politiker, Wirtschaftsvertreter und Strategen beschworen Szenarien, in denen andere Staaten, meist namentlich die USA oder China, enteilen könnten. In diesem Klima entstand eine Dynamik, die weniger von inhaltlicher Überzeugung als von präventivem Aktionismus geprägt ist. KI wurde zum Symbol politischer Handlungsfähigkeit in einer Zeit, in der klassische Steuerungsinstrumente an Wirkung verloren haben. Wer KI fördert, zeigt Aktivität. Wer zögert, riskiert den Vorwurf der Rückständigkeit.

Diese Logik erinnert an historische Phasen, in denen technologische oder militärische Entwicklungen aus ähnlichen Motiven vorangetrieben wurden. Der Vergleich mit dem Goldrausch des 19. Jahrhunderts drängt sich nicht zufällig auf. Auch damals ging es weniger um eine nachhaltige Verbesserung der Lebensverhältnisse als um schnellen Zugriff auf eine als knapp wahrgenommene Ressource. Wer zu spät kam, ging leer aus – so zumindest die Erzählung. Tatsächlich profitierten wenige, während viele scheiterten oder ausgebeutet wurden. Der entscheidende Unterschied liegt heute darin, dass die Ressource immateriell ist: Daten, Rechenleistung, Algorithmen, Know-how. Doch der Zugriff folgt ähnlichen Machtlogiken.

KI als strategische Ressource

KI ist zur neuen strategischen Ressource geworden. Staaten konkurrieren nicht mehr nur um Rohstoffe oder Produktionsstandorte, sondern um Trainingsdaten, Hochleistungschips, spezialisierte Fachkräfte und den Bau riesiger Rechenzentren. Diese Infrastruktur ist teuer, energieintensiv und langfristig wirksam. Wer sie aufbaut, legt Pfade fest, die sich über Jahrzehnte kaum korrigieren lassen. Dennoch werden entsprechende Entscheidungen häufig im Eiltempo getroffen. Förderprogramme in Milliardenhöhe werden aufgelegt, Genehmigungsverfahren beschleunigt, regulatorische Hürden abgesenkt. Parlamente und Öffentlichkeit stehen oft vor vollendeten Tatsachen.

Besonders deutlich zeigt sich diese Dynamik im internationalen Vergleich. In den USA wird KI offen als strategisches Instrument im globalen Wettbewerb definiert. Sie ist Teil sicherheitspolitischer Doktrinen, eng verknüpft mit militärischer Forschung und wirtschaftlicher Dominanz. In China fügt sich KI nahtlos in langfristige staatliche Planungen ein, die technologische Entwicklung, gesellschaftliche Steuerung und politische Kontrolle miteinander verbinden. Europa wiederum spricht von „digitaler Souveränität“, bleibt aber in zentralen Bereichen abhängig von außereuropäischen Konzernen und Technologien. Drei Machtblöcke, drei Narrative und doch ein gemeinsamer Nenner: die Furcht, abgehängt zu werden.

Das Denken ist strukturell militärisch

Diese Furcht erzeugt einen Wettlauf ohne klare Zieldefinition. KI wird ausgebaut, weil andere sie ausbauen. Investitionen rechtfertigen sich durch Investitionen. Das Denken ist strukturell militärisch: Aufrüstung erzeugt Aufrüstung. Wer innehält, verliert. Wer nachdenkt, riskiert Rückstand. In einer solchen Logik werden Grundsatzfragen schnell als Luxusproblem abgetan. Wozu soll KI konkret dienen? Welche gesellschaftlichen Probleme soll sie lösen? Wo sind ihre Grenzen? Solche Fragen gelten als nachrangig, mitunter sogar als hinderlich.

Auffällig ist dabei die Sprache, mit der dieser Prozess begleitet wird. Politiker sprechen vom „Aufholen“, vom „Anschluss sichern“, vom „Führendwerden“. Das Vokabular stammt aus dem Sport oder aus geopolitischen Rivalitätsnarrativen, nicht aus der Sozial- oder Bildungspolitik. Diese Rhetorik ist nicht neutral. Sie erzeugt Zeitdruck und legitimiert Entscheidungen, die unter normalen Umständen einer intensiven öffentlichen Debatte bedürften. Wer im Rennen liegt, hält nicht an, um über Streckenführung oder Ziel zu diskutieren.

Öffentliche Verantwortung versus private Macht

Hinzu kommt ein strukturelles Ungleichgewicht zwischen öffentlicher Verantwortung und privater Macht. Während Staaten die finanziellen Risiken tragen und öffentliche Mittel mobilisieren, liegen die entscheidenden technologischen Hebel meist in den Händen weniger Konzerne. Die größten KI-Modelle, die zentralen Plattformen, die proprietären Algorithmen gehören privaten Akteuren. Öffentliche Gelder fließen in private Infrastruktur, ohne dass Transparenz, demokratische Kontrolle oder Mitsprache in gleichem Maße gewährleistet wären. Der Staat agiert als Förderer, nicht als Gestalter.

Diese Konstellation verschärft ein bekanntes Problem moderner Technologiepolitik. Entscheidungen werden vorverlagert, nicht in Parlamente oder öffentliche Debatten, sondern in technische Architektur, in Code, in Trainingsdaten. Was dort einmal festgelegt ist, entzieht sich späterer politischer Korrektur weitgehend. Algorithmen werden implementiert, Systeme skaliert, Infrastrukturen amortisiert. Der politische Raum schrumpft, während der technische expandiert. KI wird so zum Machtfaktor, unabhängig von ihrem konkreten Nutzen.

Dabei ist längst absehbar, dass KI tiefgreifende gesellschaftliche Folgen haben wird. Arbeitsmärkte verändern sich, Entscheidungsprozesse werden automatisiert, menschliche Urteilskraft wird ergänzt oder ersetzt. Dennoch dominiert in der politischen Debatte fast ausschließlich die Perspektive nationaler Wettbewerbsfähigkeit. Soziale, ethische und demokratische Fragen erscheinen als sekundär. Wer sie in den Vordergrund rückt, gerät schnell in den Verdacht, innovationsfeindlich zu sein. Diese Zuschreibung wirkt disziplinierend. Sie begrenzt den Diskurs, noch bevor er richtig begonnen hat.

Internationale Abhängigkeiten und wachsender Technologie-Nationalismus

Ein weiterer Aspekt des KI-Rausches ist die internationale Dimension technologischer Abhängigkeiten. KI wird zunehmend als strategische Infrastruktur behandelt, vergleichbar mit Energieversorgung oder Rüstungstechnologie. Exportkontrollen für Hochleistungschips, Subventionen für Halbleiterfabriken, nationale Cloud-Initiativen sind Ausdruck eines wachsenden Technologie-Nationalismus. Gleichzeitig bleiben Datenströme global, Plattformen transnational, Lieferketten komplex. Der Versuch, KI national zu kontrollieren, kollidiert mit der Realität globaler Märkte und Konzerne.

In diesem Spannungsfeld entsteht ein paradoxes Bild: Staaten investieren massiv in KI, ohne sie tatsächlich zu beherrschen. Sie beschleunigen Entwicklungen, deren langfristige Konsequenzen sie kaum abschätzen können. Der politische Wille konzentriert sich auf das „Ob“, nicht auf das „Wie“ oder „Wozu“. KI wird damit zum Selbstzweck. Sie dient als Ersatzsymbol für politische Gestaltungskraft in einer Zeit, in der viele klassische Versprechen, von sozialem Aufstieg bis zu ökologischer Stabilität, brüchig geworden sind.

Bemerkenswert ist auch, wie selten in diesem Kontext über Verzicht gesprochen wird. Kaum ein politisches Programm thematisiert bewusst die Möglichkeit, bestimmte KI-Anwendungen nicht zu entwickeln oder nicht einzusetzen. Alles, was technisch machbar erscheint, gilt implizit als legitim. Diese Haltung markiert einen tiefgreifenden kulturellen Wandel. Technik wird nicht mehr als gestaltbares Mittel betrachtet, sondern als quasi naturgesetzliche Entwicklung, der man sich anzupassen habe. Der Mensch folgt der Maschine, nicht umgekehrt.

Der geopolitische KI-Rausch ist daher weniger ein Ausdruck technologischer Notwendigkeit als ein Symptom politischer Orientierungslosigkeit. Statt klare normative Leitplanken zu definieren, flüchten sich Regierungen in Beschleunigung. Fortschritt wird relativ verstanden, nicht daran gemessen, ob er das Leben konkret verbessert, sondern daran, ob er schneller ist als der des Nachbarn. Diese Logik verdrängt absolute Maßstäbe wie Lebensqualität, Freiheit oder soziale Gerechtigkeit.

Wettlauf ohne demokratische Zieldefinition

Gerade darin liegt die eigentliche Gefahr. Ein technologischer Wettlauf ohne demokratische Zieldefinition erzeugt Fakten, die sich später kaum noch revidieren lassen. Wer heute milliardenschwere KI-Infrastrukturen aufbaut, bindet Ressourcen, schafft Abhängigkeiten und erzeugt Nutzungsdruck. Rechenzentren wollen ausgelastet werden, Datenpools genutzt, Systeme skaliert. Was einmal möglich ist, wird früher oder später eingesetzt, nicht aus gesellschaftlicher Einsicht, sondern aus ökonomischer Logik.

So entsteht ein selbstverstärkender Kreislauf: Investitionen erzeugen Nutzungszwang, Nutzung erzeugt Abhängigkeit, Abhängigkeit rechtfertigt weitere Investitionen. In diesem Kreislauf bleibt wenig Raum für demokratische Kontrolle. Politische Debatten hinken hinterher, weil sie erst einsetzen, wenn technische Tatsachen längst geschaffen sind. KI wird zur Black Box politischer Entscheidungen.

Der geopolitische KI-Rausch ist damit kein neutraler Fortschrittsprozess, sondern ein Machtprojekt. Er verschiebt Entscheidungsgewalt weg von demokratisch legitimierten Institutionen hin zu technisch-ökonomischen Akteuren. Die zentrale Frage, warum wir bestimmte Technologien entwickeln und wem sie dienen sollen, bleibt meist unbeantwortet. Solange das so ist, gleicht jede weitere Milliardeninvestition weniger einem Zukunftsprogramm als einem Blindflug.

Damit ist der Wendepunkt erreicht – nicht, weil KI allmächtig wäre, sondern weil sie politisch zur Notwendigkeit erklärt wurde. Nicht aus Einsicht, sondern aus Angst. Und Angst war historisch selten ein guter Ratgeber für nachhaltigen, gesellschaftlich eingebetteten Fortschritt.

Der Verlust politischer Gestaltung

Der geopolitische KI-Rausch bleibt nicht folgenlos. Er wirkt tief in gesellschaftliche Strukturen hinein, verändert Entscheidungsprozesse, Machtverhältnisse und letztlich das Verhältnis zwischen Bürgern und Staat. Während politische Debatten sich auf Wettbewerbsfähigkeit, Innovationsführerschaft und technologische Souveränität konzentrieren, verschiebt sich im Hintergrund schleichend die Frage, wer eigentlich noch gestaltet und wer nur noch reagiert. KI wird nicht mehr als Werkzeug betrachtet, das gesellschaftlichen Zielen dient, sondern als System, an das sich Gesellschaften anpassen müssen. Diese Umkehrung markiert eine Zäsur.

Zunächst trifft der massive KI-Ausbau auf einen Bereich, der politisch besonders sensibel ist: den Arbeitsmarkt. Kaum eine Technologie wurde in den vergangenen Jahrzehnten so widersprüchlich diskutiert. Einerseits werden Produktivitätsgewinne, Effizienzsteigerungen und Entlastung von Routinetätigkeiten versprochen. Andererseits mehren sich Hinweise darauf, dass KI nicht nur einfache Tätigkeiten ersetzt, sondern zunehmend auch qualifizierte, wissensbasierte Arbeit. Entscheidungen, die früher menschlicher Abwägung unterlagen, werden algorithmisch vorstrukturiert oder vollständig automatisiert. Die politische Antwort darauf bleibt auffällig vage. Statt über neue Formen sozialer Absicherung, Arbeitszeitverkürzung oder Umverteilung zu sprechen, dominiert die Hoffnung, der Markt werde es richten.

Diese Hoffnung ist riskant, weil sie an einer zentralen Realität vorbeigeht: KI verändert nicht nur, was gearbeitet wird, sondern wie gesellschaftliche Wertschöpfung verteilt ist. Wer die Systeme kontrolliert, kontrolliert die Erträge. Daten, Modelle und Plattformen konzentrieren sich bei wenigen Akteuren. Der Staat, der den Ausbau fördert, gerät in eine paradoxe Rolle. Er finanziert Strukturen, die seine eigene Gestaltungsmacht untergraben können. Öffentliche Mittel fließen in private Infrastrukturen, während die demokratische Kontrolle begrenzt bleibt. Die Gesellschaft trägt die Anpassungskosten, ohne proportional an den Gewinnen beteiligt zu sein.

Noch gravierender sind die Auswirkungen auf staatliche Entscheidungsprozesse selbst. Verwaltungen setzen zunehmend auf KI-gestützte Systeme, um Anträge zu bearbeiten, Risiken zu bewerten oder Ressourcen zuzuweisen. Was als Effizienzsteigerung beginnt, verändert schrittweise die Logik staatlichen Handelns. Entscheidungen werden standardisiert, Kriterien formalisiert, Abweichungen als Störfaktoren behandelt. Der Ermessensspielraum schrumpft, nicht unbedingt aus bösem Willen, sondern aus systemischer Logik. Algorithmen arbeiten mit Wahrscheinlichkeiten, nicht mit Einzelfällen. Doch Demokratie lebt vom Umgang mit dem Besonderen.

Gefährliche Verschiebung: Verantwortung tragen „die Systeme“

Hier entsteht eine neue Form politischer Entlastung. Verantwortung wird an Systeme delegiert, deren Funktionsweise selbst für Experten oft nur eingeschränkt nachvollziehbar ist. Wenn Entscheidungen als Ergebnis „objektiver“ Berechnungen erscheinen, geraten politische Bewertungen in den Hintergrund. Fehler lassen sich externalisieren: Nicht die Politik hat entschieden, sondern das System. Diese Verschiebung ist gefährlich, weil sie die Rechenschaftspflicht aushöhlt. Demokratie basiert auf der Möglichkeit, Entscheidungen zu hinterfragen, Verantwortliche zur Rede zu stellen und Alternativen einzufordern. Black-Box-Systeme entziehen sich dieser Logik.

Besonders problematisch ist dabei, dass viele dieser Systeme auf Daten basieren, die gesellschaftliche Ungleichheiten reproduzieren. KI lernt aus der Vergangenheit. Wenn diese Vergangenheit von Diskriminierung, sozialer Selektion oder struktureller Benachteiligung geprägt ist, schreiben Algorithmen diese Muster fort. Der technologische Fortschritt tarnt alte Probleme in neuem Gewand. Doch statt diese Risiken offen zu diskutieren, werden sie oft als technische Details behandelt, die sich im laufenden Betrieb optimieren ließen. Die politische Dimension bleibt unterbelichtet.

Parallel dazu verändert sich die öffentliche Debattenkultur. KI-gestützte Systeme beeinflussen, welche Informationen sichtbar werden, welche Inhalte Reichweite erhalten und welche Stimmen gehört werden. Plattformlogiken priorisieren Aufmerksamkeit, nicht Wahrheit oder Relevanz. Was emotionalisiert, polarisiert oder bestätigt, setzt sich durch. Diese Dynamik ist kein Nebeneffekt, sondern Teil des ökonomischen Modells. Der politische Diskurs wird dadurch fragmentierter, anfälliger für Manipulation und schwerer steuerbar. Demokratie jedoch ist auf einen gemeinsamen öffentlichen Raum angewiesen, in dem Argumente abgewogen werden können.

Desinformation und Einflussnahme

Der Staat steht diesem Prozess oft ambivalent gegenüber. Einerseits warnt er vor Desinformation und Einflussnahme, andererseits nutzt er selbst datengetriebene Instrumente zur Meinungsanalyse, Sicherheitsbewertung oder Verhaltenssteuerung. Die Grenze zwischen Schutz und Kontrolle wird unscharf. KI wird damit Teil eines umfassenderen Trends zur Technokratisierung politischer Prozesse. Entscheidungen erscheinen zunehmend als technische Notwendigkeiten, nicht als politische Abwägungen. Das reduziert Komplexität, aber auch demokratische Teilhabe.

In diesem Kontext gewinnt der Begriff der „digitalen Souveränität“ eine zentrale, zugleich widersprüchliche Bedeutung. Er suggeriert Kontrolle und Selbstbestimmung, verdeckt jedoch oft reale Abhängigkeiten. Nationale KI-Strategien versprechen Autonomie, während zentrale Komponenten, von Cloud-Infrastrukturen über Trainingsdaten bis hin zu Basismodellen, von global agierenden Konzernen bereitgestellt werden. Der Handlungsspielraum des Staates beschränkt sich auf Regulierung im Nachhinein. Gestaltung im eigentlichen Sinne findet kaum statt.

Hinzu kommt ein langfristiger Effekt, der selten thematisiert wird: der Verlust politischer Vorstellungskraft. Wenn Technik als alternativlos gilt, schrumpft der Raum für gesellschaftliche Visionen. Politik reagiert, statt zu entwerfen. KI wird zur Projektionsfläche für ungelöste Probleme: Sie soll Verwaltung effizienter, Wirtschaft wettbewerbsfähiger, Sicherheit verlässlicher machen. Doch diese Erwartungen ersetzen keine politischen Konzepte. Sie verschieben Verantwortung. Statt über gerechte Verteilung, soziale Teilhabe oder demokratische Kontrolle zu sprechen, wird auf technologische Lösungen verwiesen.

Ein bewusster Verzicht erscheint als Schwäche

Diese Verschiebung zeigt sich besonders deutlich im Umgang mit Verzicht. In klassischen politischen Debatten gehört es zum Kern demokratischer Auseinandersetzung, Grenzen zu definieren. Nicht alles, was möglich ist, wird getan. Im KI-Diskurs hingegen gilt Machbarkeit oft als Legitimation. Anwendungen werden entwickelt, weil sie technisch realisierbar sind, nicht weil ihr gesellschaftlicher Nutzen überzeugend belegt wäre. Ein bewusster Verzicht erscheint als Schwäche, nicht als Ausdruck politischer Reife.

Dabei wäre gerade jetzt eine solche Debatte notwendig. Denn KI-Infrastrukturen schaffen Pfadabhängigkeiten. Rechenzentren, Datenpools und algorithmische Systeme sind keine neutralen Werkzeuge, sondern strukturieren zukünftige Entscheidungen. Sie erzeugen Nutzungsdruck und Investitionslogiken, die sich selbst verstärken. Was heute aufgebaut wird, prägt die Handlungsmöglichkeiten von morgen. Demokratische Kontrolle müsste daher frühzeitig ansetzen, bevor Systeme flächendeckend implementiert sind.

Stattdessen wird Kontrolle häufig nachgelagert gedacht. Ethikräte, Leitlinien und Selbstverpflichtungen sollen Risiken begrenzen, ohne die grundlegende Dynamik zu hinterfragen. Diese Instrumente sind nicht wirkungslos, aber sie greifen zu kurz, wenn sie den strukturellen Kontext ausblenden. Solange KI primär als geopolitisches und ökonomisches Pflichtprojekt verstanden wird, bleiben ethische Debatten randständig. Sie wirken wie Korrekturen an einem Prozess, dessen Richtung bereits feststeht.

Gesellschaften sollen sich „fit machen“ für KI – nicht umgekehrt

Der neue Goldrausch offenbart damit eine tiefere politische Krise. Er zeigt, wie sehr sich Politik von der Fähigkeit verabschiedet hat, technologische Entwicklung aktiv zu gestalten. Stattdessen dominiert Anpassung. Gesellschaften sollen sich „fit machen“ für KI, nicht umgekehrt. Bildungssysteme werden umgebaut, Arbeitsmärkte flexibilisiert, Rechtsrahmen angepasst. Die Frage, welche Art von Gesellschaft wir im digitalen Zeitalter wollen, bleibt unbeantwortet.

Wer diesen Zustand kritisiert, wird häufig missverstanden. Es geht nicht um eine Ablehnung von KI oder technologischem Fortschritt. Es geht um Prioritäten. Um die Frage, ob Technik Mittel zum Zweck bleibt oder selbst zum Zweck wird. Eine demokratische Gesellschaft müsste in der Lage sein, Technologien zu nutzen, ohne sich ihnen zu unterwerfen. Sie müsste definieren, wo KI sinnvoll ist und wo nicht.

Der historische Goldrausch endete für viele mit zerstörten Landschaften und sozialen Verwerfungen. Dem digitalen Goldrausch droht Ähnliches, nur weniger sichtbar. Seine Spuren sind nicht Flüsse und Minen, sondern Entscheidungsstrukturen, Abhängigkeiten und Machtverschiebungen. Wer heute Milliarden investiert, ohne klare gesellschaftliche Leitplanken zu setzen, schafft Fakten, die sich später kaum korrigieren lassen.

Der KI-Goldrausch ist kein Naturereignis

Der eigentliche Wendepunkt liegt daher nicht in der technischen Entwicklung selbst, sondern in der politischen Deutung. Solange KI als unvermeidliche Notwendigkeit dargestellt wird, entzieht sie sich demokratischer Gestaltung. Erst wenn sie wieder als gestaltbares Instrument begriffen wird, öffnet sich der Raum für Alternativen. Das erfordert Mut zur Entschleunigung, zur öffentlichen Debatte und zum bewussten Nein.

Angst war selten ein guter Ratgeber. Auch diesmal droht sie, Entscheidungen zu treiben, deren Konsequenzen erst sichtbar werden, wenn Korrekturen kaum noch möglich sind. Der neue Goldrausch ist kein Naturereignis. Er ist das Ergebnis politischer Entscheidungen und damit prinzipiell veränderbar. Die Frage ist nicht, ob wir KI nutzen, sondern wie, wofür und unter wessen Kontrolle. Solange diese Fragen nicht im Zentrum stehen, bleibt der technologische Fortschritt ein Risiko für demokratische Selbstbestimmung.

Quellen:

Europäische Position im globalen KI-Wettlauf

Europa liegt hinter den USA und China, sowohl was Investitionen als auch KI-Modelle betrifft – trotz eigener KI-Verordnungen und Initiativen:

„Europa will im Bereich der KI weltweit führend sein, liegt aber noch hinter den Vereinigten Staaten und China.“

Strategische Rivalität zwischen USA und China

Die Konkurrenz zwischen den USA und China um technologische Vorherrschaft ist ein zentrales geopolitisches Paradigma der internationalen Beziehungen

US-China-KI-Wettbewerb als neue geopolitische Front

Die USA und China stehen im Wettlauf um wirtschaftliche, militärische und strategische Vorteile durch KI, ein zentraler Aspekt globaler Machtpolitik

Globale KI-Rivalität und technologische Macht

Technologie wie KI ist zum Kern geopolitischer Machtkämpfe geworden, inklusive Datenkontrolle, Infrastruktur und Handelsbarrieren

EU-Initiativen für KI-Infrastruktur und „digitale Souveränität“

Die EU investiert in KI-Infrastrukturen und digitale Kompetenzen, um technologisch souverän zu bleiben

KI-Governance in verschiedenen Regionen

Vergleichsstudie zu Risikomanagement- und Governance-Modellen für KI in EU, USA, UK und China – wichtig für Debatten über Kontrolle versus Innovation

Rahmenübereinkommen des Europarats zu KI und Menschenrechten

Ein multilateraler Ansatz, KI im Einklang mit Menschenrechten, Demokratie und Rechtsstaatlichkeit zu regeln

China-US-KI-Rennen wird in Medien berichtet

China investiert massiv in KI-Infrastruktur und jagt den USA nach – ein Hinweis auf die Hochspannung im globalen Wettbewerb

IMF-Warnung zu fehlender ethischer und regulatorischer Basis für KI

Der Internationale Währungsfonds betont globale Defizite bei Regulierung und Ethik im KI-Bereich

Titelbild: Shutterstock AI / Shutterstock

Nach massiven linksextremen Krawallen verspricht Italiens Regierungschefin Meloni zahlreiche Sicherheitsverschärfungen. Zuvor wurden Polizisten mit Steinen, Molotowcocktails und Hämmern angegriffen.

Dieser Beitrag Italien Meloni plant Sicherheitsverschärfungen nach linksextremen Krawallen wurde veröffentlich auf JUNGE FREIHEIT.

Fragt man die Bundesregierung oder die zuständige Bundesnetzagentur nach der Lage der aktuellen Gasversorgung in Deutschland, demonstrieren diese maximale Gelassenheit. Ja, die Speicher seien vergleichsweise leer, aber das sei überhaupt kein Problem, da heute – anders als zu Zeiten der „Abhängigkeit von russischem Gas“ – ja alles anders sei. Man habe heute LNG-Terminals und Importmöglichkeiten aus dem europäischen Ausland. Das ist zwar richtig. Sollte der Restwinter jedoch kalt werden, wird dies nicht reichen. Man hat die Versorgungssicherheit den Märkten überlassen und die haben einmal mehr versagt. Nun hat man ein System ohne Sicherheitspuffer. Hoffen wir, dass der Winter mild zu Ende geht und vielleicht sogar ein Umdenkprozess einsetzt. Von Jens Berger.

Dieser Artikel liegt auch als gestaltetes PDF vor. Wenn Sie ihn ausdrucken oder weitergeben wollen, nutzen Sie bitte diese Möglichkeit. Weitere Artikel in dieser Form finden Sie hier.

Wie ernst ist die Lage?

Um die Versorgungssicherheit nach Verhängung der Sanktionen gegen Gasimporte aus Russland zu gewährleisten, gilt seit dem 30. April 2022 ein „Gasspeichergesetz“, das Mindestmengen für die Befüllung der deutschen Gasspeicher festlegte. So sah die ursprüngliche Version für den 1. November einen Minimalfüllstand von 95 Prozent und für den 1. Februar 40 Prozent vor. Da Deutschland vergleichsweise gut durch den ersten – jedoch auch milden – Winter ohne größere russische Gaslieferungen kam, wurden diese Werte später teils außer Kraft gesetzt, teils gesenkt. Aktuell gelten für November unterschiedliche Zielvorgaben je nach Speichertyp (dazu später mehr) und für den 1. Februar gilt ein Zielwert von nur noch 30 Prozent. Diesen Wert haben die deutschen Speicher – wenn auch denkbar knapp – mit 31,97 Prozent trotz des in diesem Jahr vergleichsweise kalten Winters eingehalten. Besteht also kein Grund zur Sorge, wie die Bundesnetzagentur gebetsmühlenartig behauptet? Oh, doch.

Dazu zunächst die Durchschnittswerte aus dem Januar. Im Schnitt importierte Deutschland jeden Tag inkl. der LNG-Lieferungen 3.090 GWh Gas. Zum Vergleich: Im „Vorkriegswinter“ 2021/2022 waren es im Schnitt noch 2.000 GWh mehr. Die eigene Förderung ist mit 89 GWh pro Tag eher zu vernachlässigen. Im Januar haben Haushalte, Gewerbe und Industrie pro Tag im Schnitt 4.210 GWh Gas verbraucht. Zwischen Import sowie Förderung und Verbrauch gibt es also eine Differenz von etwa 1.000 GWh pro Tag. Das allein wäre kein Problem, entspricht der derzeitige Füllstand der Speicher von 31,97 Prozent doch rund 81.000 GWh, was bei gleichbleibenden Ein- und Ausspeisungen bis in den Frühling reichen würde. Deutschland importiert jedoch nicht nur Gas, es exportiert es auch – vor allem in die Länder (Tschechien, Polen, Österreich), die früher besonders viel russisches Gas bezogen, aber nun dank der Sanktionen über Deutschland aus den gleichen Quellen versorgt werden, aus denen auch Deutschland sein Gas bezieht. Die Exporte betrugen im Januar im Schnitt 858 GWh pro Tag, was die Differenz auf exakt 1.889 GWh pro Tag erhöht. Rechnet man mit dieser Zahl und gleichbleibenden Parametern, wären die deutschen Speicher am 16. März komplett leer.

In der Branche kalkuliert man übrigens mit dem 1. April als Ende des „Versorgungswinters“ – erst dann können bei „normalem Wetter“ die Speicher wieder gefüllt werden, weil weniger verbraucht als ins Netz eingespeist wird. Mit anderen Worten: Wenn die nächsten Wochen genau so kalt wie der Januar werden und keine Verbraucher vom Netz getrennt werden, reichen die Gasvorräte nicht aus, um eine Versorgung bis zum Ende des Winters zu gewährleisten.

Was ist von den beschwichtigenden Erklärungen der Regierung zu halten?

Nun heißt es seitens Regierung und Behörden aber, dass die Annahme, die Parameter seien konstant, nicht zutreffend sei. Die Bundesnetzagentur schreibt dazu Folgendes:

Die Versorgungslage hat sich in den vergangenen Jahren verändert. Deutschland verfügt über unterschiedliche Importmöglichkeiten. Gasmengen können über Pipelines (insb. aus Norwegen) sowie über LNG-Terminals importiert werden. Außerdem hat Deutschland in den vergangenen Jahren die Gasflüsse von einem sogenannten Ost-West-Fluss auf einen Nord/West-Ost-Fluss umgestellt, sodass weitere Importmöglichkeiten über Frankreich und Belgien erschlossen worden sind. Deutschland ist eng in das europäische Gasverbundsystem integriert, was flexible Gastransporte ermöglicht. Der europäische Energiebinnenmarkt ist entscheidend für die Versorgungssicherheit mit Gas. Die grenzüberschreitende Zusammenarbeit funktioniert sehr gut.

Gehen wir die Punkte doch einmal durch. Fangen wir mit den Importmöglichkeiten an. Richtig ist, dass Norwegen in den letzten Jahren Russland als mit Abstand größter Gaslieferant für den deutschen Markt ersetzt hat, und richtig ist auch, dass die vorhandenen Pipelines große Importmengen gewährleisten. Laut Planungsunterlagen sind dies max. 1.537 GWh pro Tag. Das entspricht den russischen „Vorkriegslieferungen“. Das Problem: Diese Maximalkapazität wird bereits jetzt voll ausgereizt. Allein Deutschland bezog im Januar im Schnitt 1.359 GWh pro Tag aus Norwegen. Die genaue Zahl, wie hoch der Anteil norwegischen Gases bei den Mengen ist, die Deutschland rechnerisch exportiert, bei denen wir also nur Transitland sind, ist nicht exakt in Erfahrung zu bringen. Jedwede Puffer gibt es hier jedoch nicht.

Derzeit liefert Norwegen bereits so viel Gas, wie bei bestehender Infrastruktur möglich ist. Sollte es übrigens Probleme auf den norwegischen Feldern oder an den Pipelines geben, wäre dies auch ohne Wetterverschärfung eine einzige Katastrophe. Heißt es doch, Deutschland sei früher abhängig von russischem Gas gewesen, muss es heute heißen, Deutschland ist ohne Wenn und Aber abhängig von norwegischem Gas. Es existieren keine Puffer und Alternativen in dieser Größenordnung. Ganz ähnlich sieht es übrigens mit den übrigen Lieferanten für Pipelinegas aus. Auch die Leitungen aus den Niederlanden und Belgien sind an bzw. kurz vor der technischen Maximalauslastung.

Wie sieht es mit den anderen Ländern aus? Es müssen ja nicht zwingend „frisch“ geförderte Gasmengen sein. Im Spannungs- oder gar Notfall könnte Deutschland ja auch Gas aus den Speichern seiner Nachbarn beziehen. Das stimmt. Für die Niederlande und Belgien gilt jedoch, dass es dafür nicht nur keine Leitungskapazitäten gibt, sondern dass die beiden Länder auch mit 25 bzw. 31 Prozent ähnlich niedrige Füllstände wie Deutschland aufweisen. Frankreich ist übrigens auch keine echte Alternative, sind dort die Speicher mit 30 Prozent doch ähnlich leer und hinzu kommt, dass Frankreich ohnehin nur ein geringes Speichervolumen hat. Polen hat auch nur vergleichsweise geringe Speicher, die jedoch mit 64 Prozent erstaunlich voll sind. Kein Wunder, das Gas fließt ja auch in der umgekehrten Richtung von Deutschland nach Polen. Ist eine „Rückwärtsversorgung“ möglich? Technisch ja, politisch ist das wohl eher unwahrscheinlich. Bleiben zwei Länder, die vergleichsweise große Speicher haben, die zudem zurzeit auch gut gefüllt sind – Österreich (45 Prozent) und Italien (57 Prozent), die in Summe rund doppelt so viel Gas wie Deutschland gespeichert haben. Das Problem ist hier jedoch, dass es keine ausreichenden Leitungskapazitäten für eine Versorgung Deutschlands aus dem Süden gibt. Über den „Hochleistungsimportpunkt“ Oberschlauersberg könnte Deutschland theoretisch maximal 144 GWh pro Tag aus Österreich oder Italien importieren. Das könnte für die südlichen Teile Bayern als Notversorgung reichen – mehr aber auch nicht.

Kommen wir zum LNG und damit zum großen Fragezeichen. Korrekt ist, dass es beim LNG-Import zumindest auf dem Papier in der Tat noch freie Reserven gibt. Rein theoretisch könnte Deutschland rund 1.000 GWh LNG pro Tag einspeisen, zurzeit sind es „lediglich“ rund 400 GWh. Die große Frage ist hierbei jedoch, wo dieses Gas herkommen soll. Weltweit sind die großen LNG-Lieferströme über Festverträge oder Warentermingeschäfte bereits lange im Voraus gebucht. Zusätzliche Mengen könnte man sicher zu Mondpreisen auf dem Spotmarkt kaufen – bis die Tanker an den Terminals in Nord- und Ostsee ankommen, könnte dies jedoch zu spät sein. Da die Umwandlung von Flüssiggas in gasförmiges Erdgas zudem bei niedrigen Außentemperaturen weniger effizient ist, stellt sich die Frage, wie hoch die realistische Maximaleinspeisung überhaupt ist. In jüngerer Vergangenheit konnten an keinem Tag mehr als 510 GWh eingespeist werden. Realistisch ist hier also ein Puffer nicht mehr als maximal 200 GWh vorstellbar. Das würde im oben genannten Szenario das Leerlaufen der Speicher aber auch nur um ein paar Tage hinauszögern.

Der „grenzüberschreitende“ Gashandel, auf den die Bundesnetzagentur so stolz verweist, ist nun einmal für den Normalzustand ausgelegt. Um mitten im Winter unabhängig von den Speichern die Volkswirtschaft zu versorgen, reichen die Kapazitäten hier nicht einmal im Ansatz.

Wovon die Behörden nicht sprechen

Mindestens ebenso spannend wie die vagen, teils unzutreffenden Aussagen der Bundesnetzagentur ist das, was sie nicht sagt. Implizit suggeriert man bei der Thematik ja immer, dass die Speicher im Notfall tatsächlich bis zum letzten Kubikmeter Gas geleert werden können. Doch das ist technisch gar nicht möglich. In Deutschland gibt es Kavernen- und Porenspeicher. Sind erstere relativ unproblematisch, sind Porenspeicher nicht dafür konzipiert, in akuten Kältewellen sehr schnell sehr große Mengen Gas abzugeben. Hinzu kommt, dass die Abgabeleistung mit fallendem Füllstand sinkt. Man kann sich das so vorstellen: Je niedriger der Füllstand, desto niedriger der Druck in einem Porenspeicher, desto niedriger die maximale Entnahmeleistung. In Studien wird hier eine Grenze bei einem Füllstand von rund 20 Prozent genannt – ist der Füllstand unter dieser Marke, kann das Gas nur noch sehr langsam abgegeben werden.

Dumm nur, dass sowohl in Deutschland als auch bei unseren Nachbarn die größten Speicher eben jene Porenspeicher sind. Der größte deutsche Speicher ist das UGS Rehden und hat derzeit einen Füllstand von 9,41 Prozent. Mehr als rund 0,2 Prozent lassen sich den Daten zufolge derzeit aus diesem Speicher nicht entnehmen. Der größte Speicher Europas ist das UGS Bergermeer, der derzeit bei 26,41 Prozent steht, sich aber täglich zwischen 0,5 und 1,0 Prozent leert, also bereits in wenigen Tagen nicht mehr mit voller Leistung ins Netz einspeisen kann.

Wenn also der Gasverbrauch auch in den nächsten Tagen und Wochen deutlich über den Importen liegt, dürfte dies auch dazu führen, dass die leistungsfähigeren Kavernenspeicher einen Großteil der Differenz ausgleichen und sich dementsprechend schnell leeren könnten. Der Gasnotstand – also der Tag, an dem der Verbrauch nicht mehr durch Einspeisungen ins Netz gewährleistet werden kann – könnte also bereits lange vor dem Tag kommen, an dem alle Speicher physisch leer sind.

Was sind die Gründe für die prekäre Lage?

Ein flexibles Versorgungsnetz mit vielen unterschiedlichen Importoptionen – das hört sich doch gut an. Und den Rest erledigen die Märkte. Prima. In der Theorie ist das auch so. Die Gasversorgungsinfrastruktur ist aber speziell. Wie oben dargelegt reichen die Kapazitäten in der Heizperiode im Winter nicht aus, um den Verbrauch synchron durch die Gasimporte zu decken. Man muss also in den warmen Jahreszeiten Vorräte einbunkern, die in den kalten Jahreszeiten die Differenz ausgleichen. Privatwirtschaftliche Akteure machen das freilich nur, wenn es sich rechnet. Und genau das war in den letzten Jahren mit ihren recht milden Wintern nicht der Fall. Angebot und Nachfrage.

Hinzu kommt, dass die Gasabnahme sich durch die Energiewende verändert hat. Deutschland ist raus aus dem Atomstrom und hat die Kohlestromkapazitäten zurückgefahren. Gaskraftwerke haben nun die wichtige Funktion, vor allem nachts und bei wenig Wind die Lücken zu füllen, die Photovoltaik und Windenergie aufreißen. Das ist ja technisch auch machbar, hat jedoch Folgen für den Gaspreis. Durch die vor allem durch die Stromerzeugung geänderten Abnahmeprofile für Gas ist in den letzten Jahren das „klassische Geschäftsmodell“ der Unternehmen weggefallen, die Gas einspeichern. Im Sommer ist das Gas heute nicht mehr so preiswert, in milden Wintern nicht mehr so teuer. Die Folge: Da das Geschäft nicht mehr so lukrativ ist, speichert man halt weniger Gas ein. Und was hat die Regierung gemacht? Sie hat die einst recht restriktiven Richtlinien aufgeweicht und aus den gesetzlichen Mindestvorgaben lasche Zielwerte gemacht.

Es kam, wie es kommen musste. Zu Beginn der Heizperiode im November waren die deutschen Speicher nicht wie sonst mit 90 Prozent, sondern nur mit 75 Prozent gefüllt. Diese 15 Prozent machen nun den Unterschied. Offenbar hat man zudem die eigenen Prognosen zum Klimawandel ein wenig zu ernst genommen und mit einem viel zu milden Szenario gerechnet.

Wie wahrscheinlich ist die Mangellage?

Auch wenn der Winter bislang vergleichsweise kalt war, ist es immer noch möglich, dass die Mangellage ausbleibt. Studien rechnen hier mit verschiedenen Szenarien und benennen dabei drei Risikofaktoren: Das bereits erwähnte Problem mit den Porenspeichern, technische Probleme bei der Infrastruktur und natürlich das Wetter. Wäre der Rest des Winters – wie z.B. 2020 – außergewöhnlich warm, wären keine Probleme zu erwarten und es gäbe sogar noch Puffer. Bleiben Februar und März im langjährigen Mittel, kommen wir – wenn auch nur knapp – mit dem Gas durch den Restwinter, es bestehen jedoch keine Sicherheitspuffer, auf die das System eigentlich ausgelegt sein sollte. Sollten Februar und März allerdings – wie z.B. 2010 – außergewöhnlich kalt werden, tritt die Gasmangellage vor Ende der Heizsaison ein.

Für ein solches Szenario gibt es freilich Pläne. Zunächst wird – vereinfacht gesagt – die Schwerindustrie vom Netz genommen. Dann werden die Exporte gestoppt – sollen doch die Österreicher und die Tschechen frieren. Erst wenn gar nichts mehr geht, kommt es auch zu Einschränkungen bei der Versorgung der Haushalte.

Offen ist jedoch ein weiterer Punkt. Der Januar 2026 zeichnete sich auch dadurch aus, dass noch nie so viel Gas zur Stromproduktion eingesetzt wurde. Das ist sogar verständlich, scheint im Januar doch wenig Sonne. Das wird in der gesamten Debatte erstaunlicherweise kaum bedacht. Was passiert also, wenn es in den nächsten Wochen nicht nur kalt wird, sondern auch dunkel bleibt und der Wind nur schwach weht? Das wäre dann wohl die „perfekte Kombination“ für eine Versorgungskrise, bei der nicht nur die Gasheizung, sondern auch flächendeckend die Stromversorgung Probleme bekommen könnte.

Krise ante portas. Doch freilich muss es nicht dazu kommen. Wenn das Wetter sich in den nächsten Tagen und Wochen verbessert, die Sonne scheint und der Wind weht, werden wir aus der selbstverschuldeten Krise noch einmal mit einem blauen Auge herauskommen. Wird die Politik dann auch ihre Lehren daraus ziehen? Die derzeitige Kommunikation legt den Verdacht nahe, dass dies nicht so sein wird. Man redet die Gefahr klein und tut gerade so, als gäbe es gar kein Szenario, in dem es zu einer Mangellage kommen könnte. Denn dann wäre die Strategie, alles den Märkten zu überlassen, ja nicht mehr haltbar. Der Staat müsste selbst aktiv werden und womöglich käme sogar jemand auf die „dumme Idee“, einmal die Frage zu stellen, ob die Sanktionen gegen Russland nicht einmal hinterfragt werden sollten. Denn eins steht fest: Hätten wir die 1.500 GWh pro Tag, die vor den Sanktionen noch flossen, heute zumindest als Option, hätten wir auch keine drohende Gasmangellage. Die Politik ignoriert das, der Wähler muss wohl erst daheim frieren, bis er die Brisanz der Thematik wirklich versteht. Vielleicht ist es aber auch die Industrie, die nun die Alarmglocken schlägt. Denn sie wird als Erstes betroffen sein, sollte es kalt bleiben, und Gas und womöglich auch Strom rationiert werden.

Titelbild: Mike Mareen/shutterstock.com

Millardenverlust und Offshore-Ausstieg. Wie in Baden-Württemberg Landkreise, Sparkassen und sogar die evangelische Landeskirche für ein politisches Energieabenteuer bluten müssen – und welche Rolle der grüne Finanzminister Danyal Bayaz dabei spielt.

Die Nachricht schlug im baden-württembergischen Energiekonzern EnBW und im politischen Stuttgart ein wie eine Bombe: Der Energieversorger aus Karlsruhe musste rund 1,2 Milliarden Euro abschreiben, nachdem er sich aus zwei geplanten Offshore-Windpark-Megaprojekten vor der Küste Großbritanniens zurückgezogen hatte. Die Projekte „Mona“ und „Morgan“, gemeinsam mit BP geplant, galten als Prestigevorhaben und sollten den Beweis dafür liefern, dass die Energiewende auch ohne Kernkraft und Kohle funktionieren könne.

Doch dann blieb die staatliche Förderung aus. Nach mehreren Auktionen ohne Zuschlag zog EnBW die Reißleine. In der nüchternen Konzernmitteilung heißt es, steigende Kosten in der Lieferkette, gesunkene Großhandelspreise, höhere Zinsen und Projektumsetzungsrisiken hätten die Wirtschaftlichkeit zerstört. Im Klartext: ohne Subventionen keine Windräder. Offshore-Wind rechnet sich nicht – jedenfalls nicht ohne Steuergeld.

Die 1,2 Milliarden sind nun weg. Genau das macht den Vorgang hoch brisant. Denn EnBW hatte sich zuvor unter dem wohlklingenden Label „Netzausbau“ frisches Geld besorgt, nicht bei privaten Investoren, sondern bei Landkreisen, Kreissparkassen und sogar bei der evangelischen Landeskirche. Sie alle sind über das sogenannte Südwest-Konsortium mit 24,95 Prozent an TransnetBW beteiligt, dem Übertragungsnetzbetreiber der EnBW. Und sie tragen nun das Risiko mit.

Erstaunlich ruhig und gelassen fiel die politische Reaktion aus. Motto: Nun sind sie halt weg, die 1,2 Milliarden. Ein Sprecher des grünen Finanzministers Danyal Bayaz lobte den Rückzug als „verantwortungsvolle Entscheidung zur Begrenzung weiterer Risiken“. Das verwundert. Bayaz sitzt selbst im Aufsichtsrat der EnBW. Und mehr noch: Ohne seine Strategie wäre dieses Risiko nie so breit gestreut worden.

Denn der frühere Unternehmensberater Bayaz nutzte einen juristischen Hebel, den kaum jemand auf dem Schirm hatte. Seit 2001 sind Anstaltslast und Gewährträgerhaftung für Sparkassen offiziell abgeschafft, nachdem die EU sie als Wettbewerbsverzerrung untersagt hatte. Doch es gibt eine Ausnahme: Geschäfte der öffentlichen Daseinsvorsorge. Energieversorgung fällt darunter – und inzwischen auch der Klimaschutz. Das gilt heute als gängige Rechtsauffassung.

Genau hier setzte Bayaz an. Private Investoren wollten das Risiko des Netzausbaus nicht tragen. Also wurden öffentliche Institute mobilisiert: Sparkassen, Versicherungen, kirchliche Einrichtungen. Alles Akteure mit politischem Auftrag, langfristigem Anlagehorizont und mit staatlicher Rückendeckung inklusive. Formal haftet niemand unbegrenzt. Materiell aber wird das Risiko kollektiviert.

Über 30 Kreissparkassen sind am Südwest-Konsortium beteiligt. Jede von ihnen steht in enger Verbindung zu ihren Trägerkommunen. Damit wurde die Haftung horizontal ausgeweitet: Nicht mehr nur die an der EnBW beteiligten Landkreise, sondern zahllose Kommunen im ganzen Land hängen nun mit drin. Viele dürften gar nicht wissen, wie tief.

Noch im Mai 2023 feierte man das Geschäft. Der Präsident des Sparkassenverbands sprach von „historischer Bedeutung“. Die Sparkasse Zollernalb erklärte stolz, man leiste einen „wertvollen Beitrag zur Energiewende“. Heute zeigt sich: Das war kein Beitrag, sondern ein Risikotransfer.

Im Landtag wächst nun der Unmut. Die FDP verlangt Aufklärung, ob der Milliardenverlust absehbar war, als EnBW frisches Kapital einwarb. Die AfD kündigt einen Untersuchungsausschuss an. Von „politisch gedecktem Zockertum“ ist die Rede.

Das alles fällt nun auch der CDU auf die Füße. Sie ist über kommunale Beteiligungen tief in die EnBW-Struktur eingebunden, hat die politisierte Unternehmensführung mitgetragen und kritische Fragen vermieden. Manuel Hagel, Spitzenkandidat und neuer Hoffnungsträger der CDU im Südwesten, war zuvor Sparkassen-Filialleiter in Ehingen bei Ulm; höchst unwahrscheinlich, dass er von den windigen Geldflüssen oberschwäbischer Sparkassen und Banken nichts wusste. Jetzt ruft er dazu auf: „Wir werden mehr arbeiten müssen. Wir werden länger arbeiten müssen!“ Klar, 1,2 Milliarden sind noch eine Menge Geld, dafür muss schon mehr gearbeitet werden.

Die Grünen wiederum haben die Energiewende nie als technischen Umbau verstanden, sondern als moralisches Projekt. Gesicherte Leistung galt als politisches Übel. Die FDP schließlich lieferte das ökonomische Feigenblatt.

Der EnBW-Milliardenverlust ist damit kein Betriebsunfall. Er ist der erste Belastungstest eines Systems, das Risiken verschleiert, Verantwortung streut und Verluste sozialisiert. Noch liegt der Schaden bilanziell bei der EnBW. Doch die Logik dahinter ist längst weitergezogen – bis in die kommunalen Haushalte und kirchlichen Vermögensverwaltungen hinein.

Kein Wunder also, dass mittlerweile Panik bei den Aktionären herrscht. Denn das Abenteuer Energiewende zeigt jetzt sein wahres Gesicht: teuer, riskant – und am Ende zahlen andere. Sozialismus eben.

Der Beitrag erschien zuerst bei TE hier

Der Beitrag Das EnBW-Debakel als Spiegelbild der scheiternden Energiewende erschien zuerst auf EIKE - Europäisches Institut für Klima & Energie.

Aus freigegebener E-Mail-Korrespondenz aus dem Jahr 2014 entsteht ein detailliertes Bild davon, wie Jeffrey Epstein sich als Vermittler innerhalb des Netzwerks des World Economic Forum (WEF) präsentierte – insbesondere im Zusammenhang mit dem prestigeträchtigen Programm Young Global Leaders (YGL).

Die E-Mails zeigen, wie Epstein seine persönlichen Kontakte zu einflussreichen Akteuren nutzte, um die Nominierung der deutschen Unternehmerin und Investorin Nicole Junkermann für das YGL-Programm voranzubringen.

Ze wordt echter niet uitgekozen. Epstein laat weten haar volgend jaar wel “gegarandeerd” YGL te laten worden. Epstein vraagt Larry Summers om een nominatie. Ze zegt vervolgens toe naar zijn eiland te komen, allemaal in de Epstein files terug te vinden: https://t.co/fuOcdmXGH1

— Pepijn van Houwelingen (@PvanHouwelingen) February 1, 2026pic.twitter.com/t0sxDDKsp0

Das Young-Global-Leaders-Programm des WEF hat zum Ziel, jährlich eine ausgewählte Gruppe junger, einflussreicher Persönlichkeiten zu identifizieren, auszuzeichnen und miteinander zu vernetzen. Kandidaten werden in der Regel über Nominierungen vorgeschlagen, denen ein Auswahlverfahren folgt. In der vorliegenden Korrespondenz erweckt Epstein jedoch den Eindruck, nicht nur Zugang zu diesem Prozess zu haben, sondern auch Einfluss auf dessen Ausgang ausüben zu können.

Am 9. Januar 2014 schreibt Junkermann an Epstein, dass sie bereits von zwei Personen für das YGL-Programm nominiert worden sei. Sie fragt ihn ausdrücklich, ob er „ein wenig nachhelfen“ und der Nominierung zusätzlichen Nachdruck verleihen könne.

Einige Wochen später wird deutlich, dass Junkermann in diesem Jahr nicht ausgewählt wurde. Als sie Epstein am 21. Februar 2014 darüber informiert, reagiert dieser auffallend bestimmt:

„Ok, dieses Jahr überlasse es mir. Ich kann es garantieren.“

Mit dieser Aussage suggeriert Epstein, er sei in der Lage, ihre Aufnahme in das Programm im darauffolgenden Jahr sicherzustellen.

Im gleichen Zeitraum erkundigt sich Epstein danach, wo sich Junkermann gerade aufhält, und lädt sie ein, Ende März seine Privatinsel zu besuchen. Kurz darauf bestätigt Junkermann das Vorhaben mit den Worten: „Island good.“

Der zeitliche Zusammenhang zwischen dieser Einladung und Epsteins Zusage, ihre YGL-Nominierung „zu regeln“, wirft Fragen nach der Natur und dem Kontext dieser Kontakte auf.

Im Juli 2014 geht Epstein einen Schritt weiter. Er kontaktiert Larry Summers, den ehemaligen US-Finanzminister und früheren Präsidenten der Harvard University, mit der Bitte um einen Gefallen. In einer E-Mail ersucht Epstein Summers um eine zweite Nominierung sowie um eine positive Empfehlung für Junkermann, die er als „sehr gute Freundin“ bezeichnet.

Epstein hebt dabei Junkermanns wirtschaftlichen Erfolg hervor: Sie habe einen Hedgefonds gegründet und damit Hunderte Millionen Dollar verdient. Summers reagiert mit Rückfragen zum YGL-Programm und zur vorherigen Nominierung, stellt jedoch zugleich explizite Fragen zu Junkermanns Intelligenz und ihrem äußeren Erscheinungsbild.

In den folgenden E-Mails bestätigt Epstein, dass das YGL-Programm eine Untereinheit des World Economic Forum ist und dass eine frühere Nominierung von Boris Nikolic stamme, einem früheren Mitarbeiter von Bill Gates, der später mit dem Investor Vinod Khosla zusammenarbeitete.

Summers macht in seinen Antworten mehrfach sexuell konnotierte Bemerkungen über Junkermanns Aussehen und bezeichnet sie unter anderem als „sehr attraktiv“. Epstein reagiert darauf mit dem Hinweis, dass derartige Einschätzungen besser nicht in einer formellen Empfehlung erscheinen sollten. Summers entgegnet anschließend, er glaube, Junkermann von einem früheren Treffen in Gabun zu kennen.

Die Korrespondenz wirft grundsätzliche Fragen über die Kultur innerhalb elitärer Netzwerke wie dem Young-Global-Leaders-Programm auf. Sie legt nahe, dass persönliche Beziehungen, Reputation und sogar äußere Erscheinung eine Rolle in Empfehlungsprozessen spielen könnten, die offiziell auf Führungsqualitäten, Leistung und gesellschaftlichem Engagement basieren sollen.

Gleichzeitig bieten die E-Mails einen seltenen Einblick in informelle Machtstrukturen und soziale Dynamiken an den Rändern internationaler Elite-Netzwerke – und in die Rolle, die Jeffrey Epstein in diesem Umfeld einzunehmen wusste.

Die Verfahren von Migranten gegen abgelehnte Asylbescheide erreichen einen neuen Rekord. Die Verwaltungsgerichte kommen kaum noch hinterher. Andere Entscheidungen verzögern sich.

Dieser Beitrag Weiterer Anstieg um 50 Prozent Richterbund beklagt „neue Asylklagewelle“ wurde veröffentlich auf JUNGE FREIHEIT.

Human rights organizations reacted with outrage and disgust in the past week following a friendly visit to China by the secretary-general of the Organization of Islamic Cooperation (OIC), Hissein Brahim Taha, in which he declared that his group would "continue to firmly support China" in its genocide of Muslims in occupied East Turkistan.

The post Organization of Islamic Cooperation Offers ‘Firm Support’ to Chinese Genocide of Muslims appeared first on Breitbart.

Nach einer Umfrage findet nur eine knappe Mehrheit, die Gebietsabtretung sei inakzeptabel. Berücksichtigt man neben anderen Vorbehalten gegenüber dem Ergebnis den eingeräumten hohen statistischen Fehler sieht es für die Politik von Kiew und Europa nicht mehr so gut aus.

Der Beitrag Sind die Ukrainer bereit, die von Russland geforderten Gebiete im Donbass abzutreten? erschien zuerst auf .